名词解释

- 深度学习:

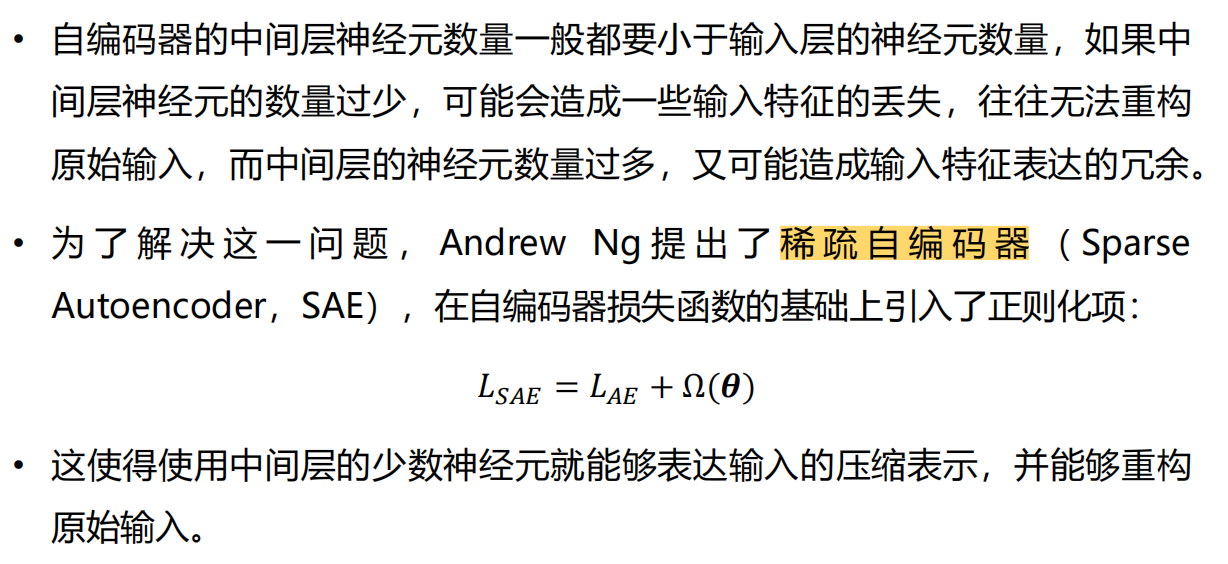

- 稀疏自编码器:

- 正则化:

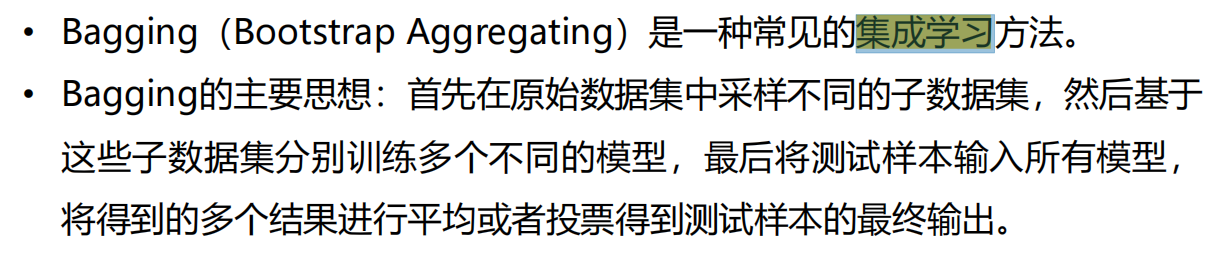

- 集成学习:

- Dropout:

- 卷积神经网络:

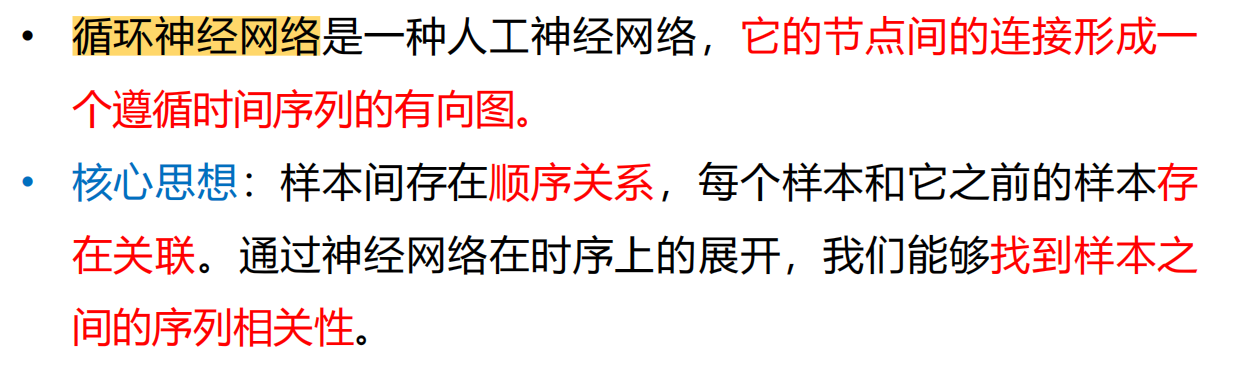

- 循环神经网络:

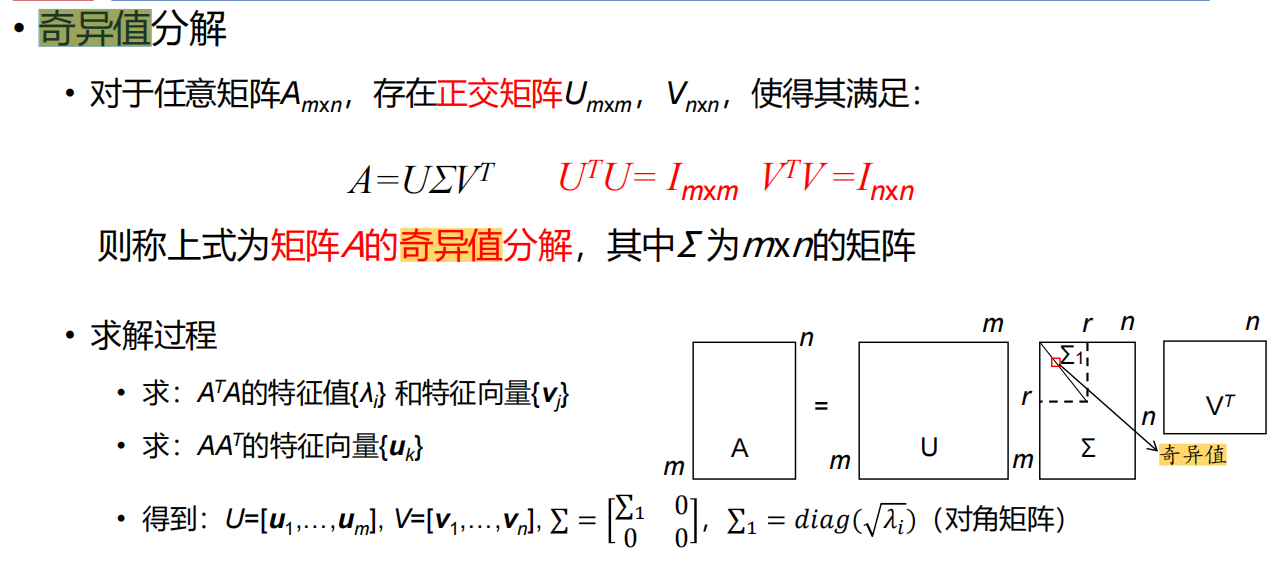

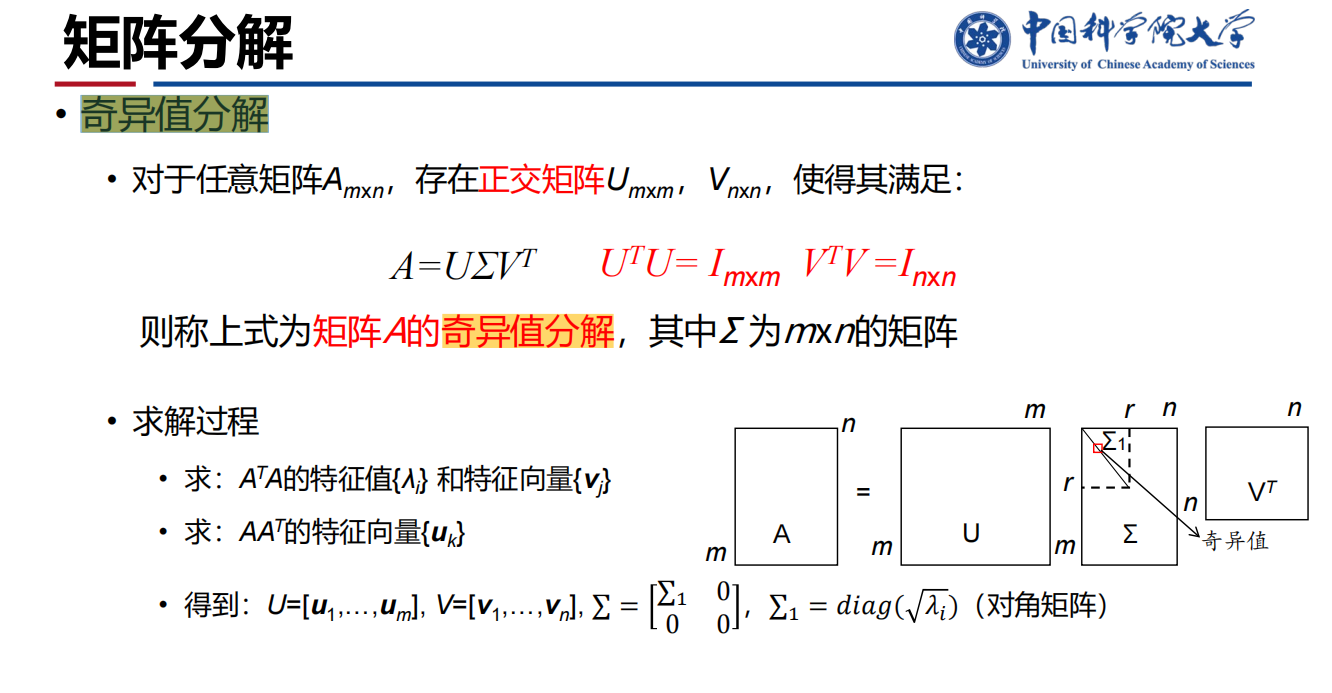

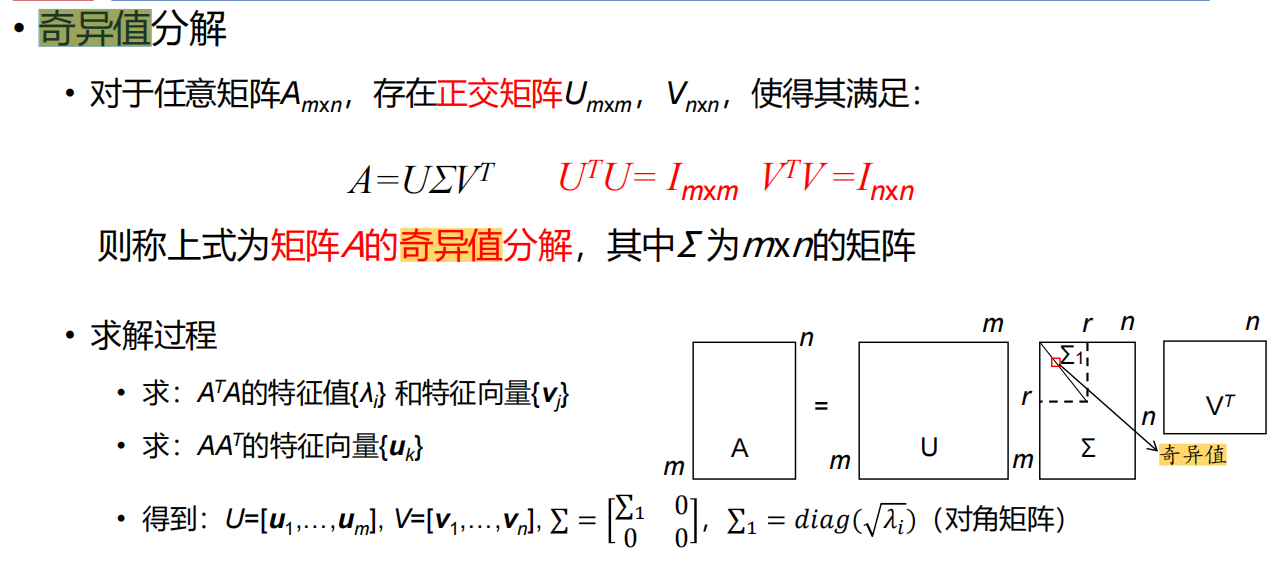

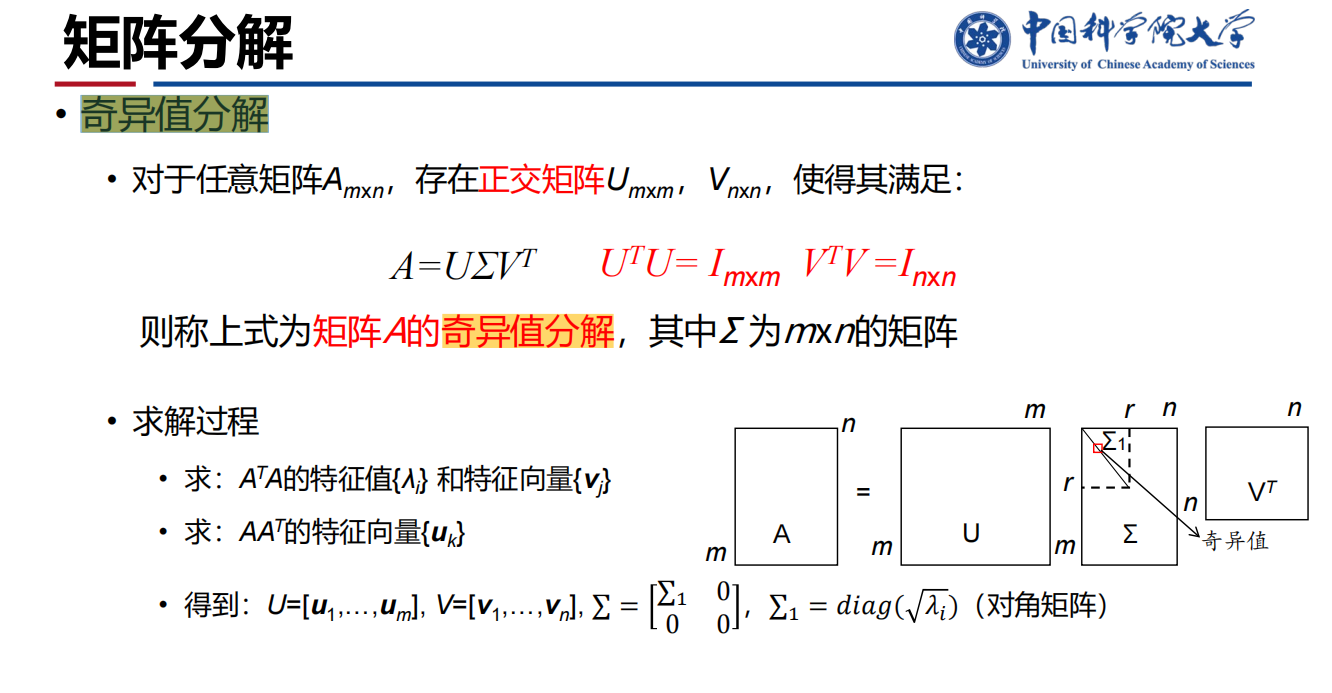

- 奇异值分解:

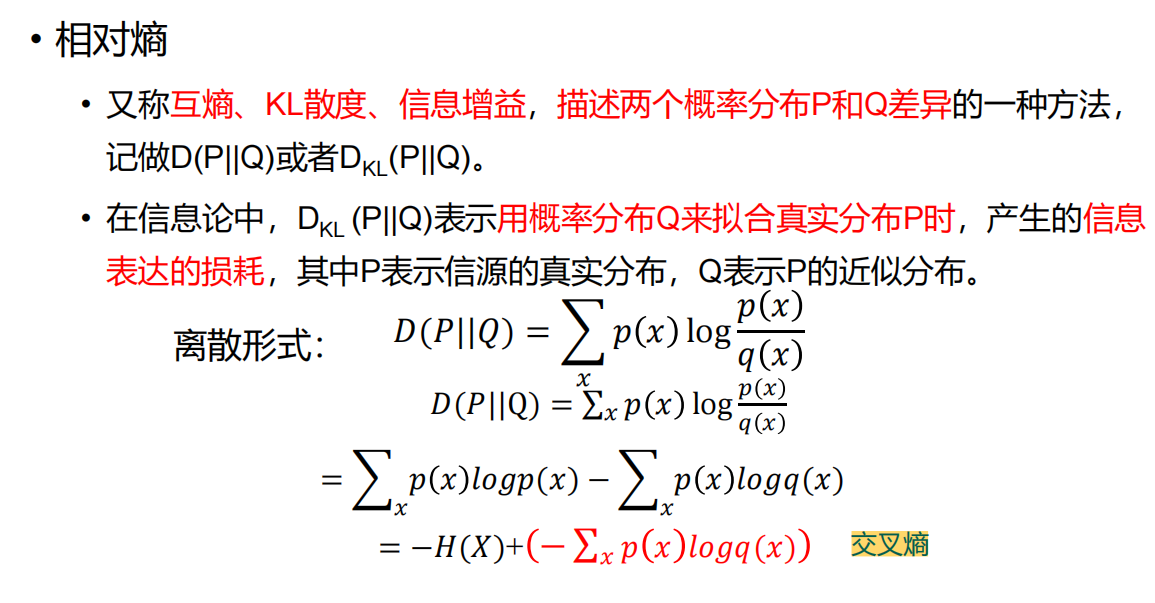

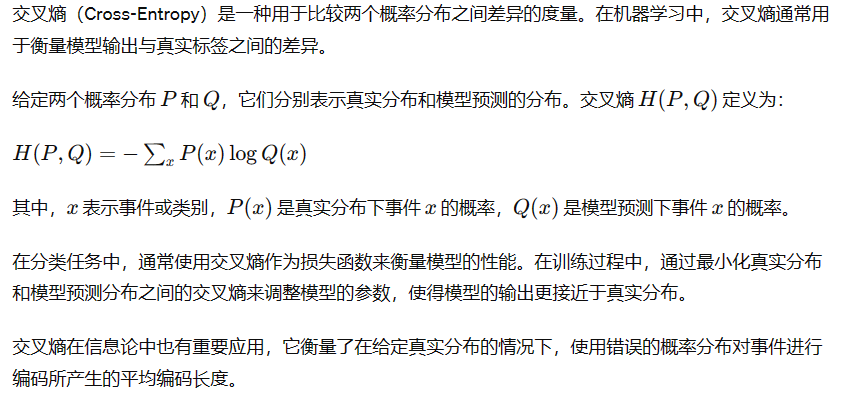

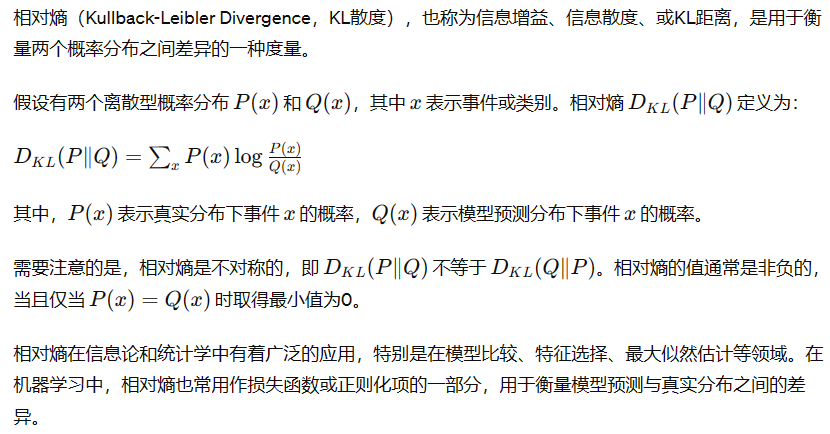

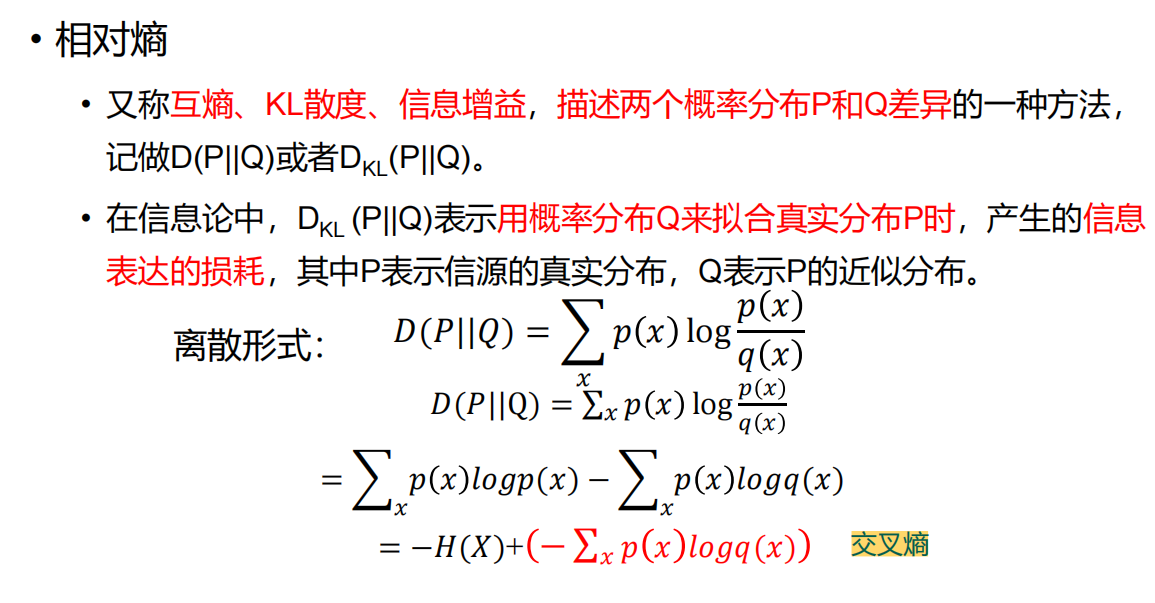

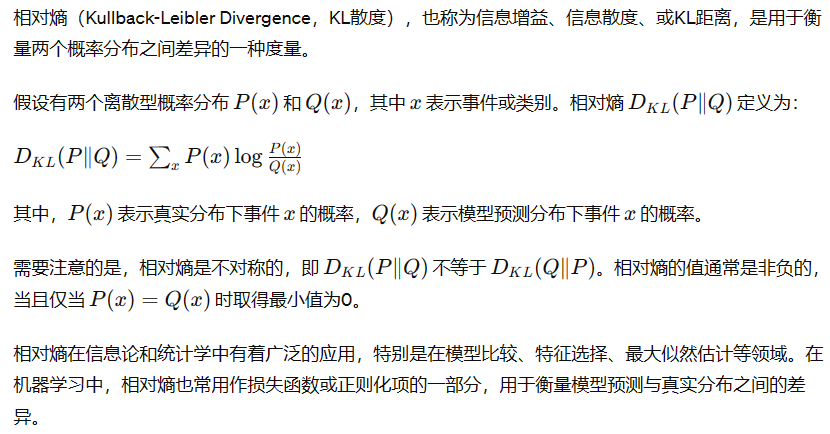

- 交叉熵/相对熵:

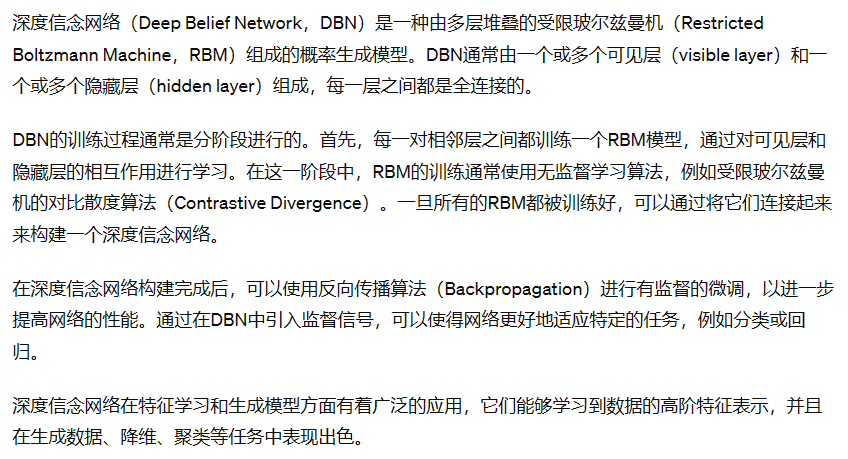

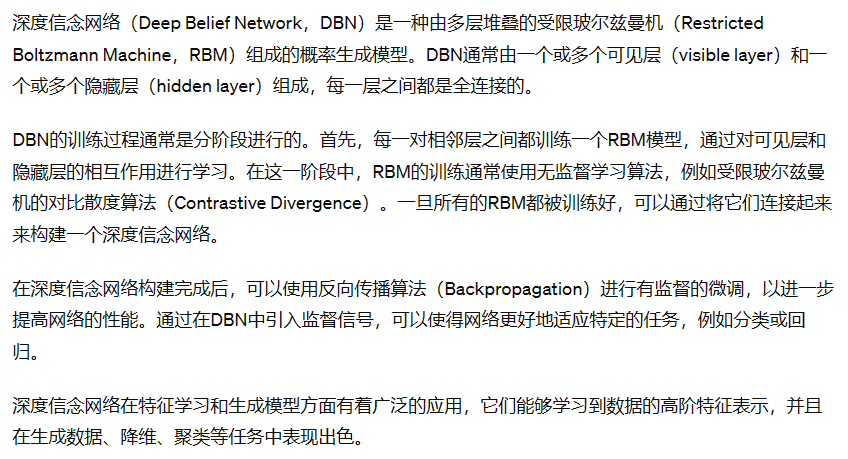

- 深度信念网络:

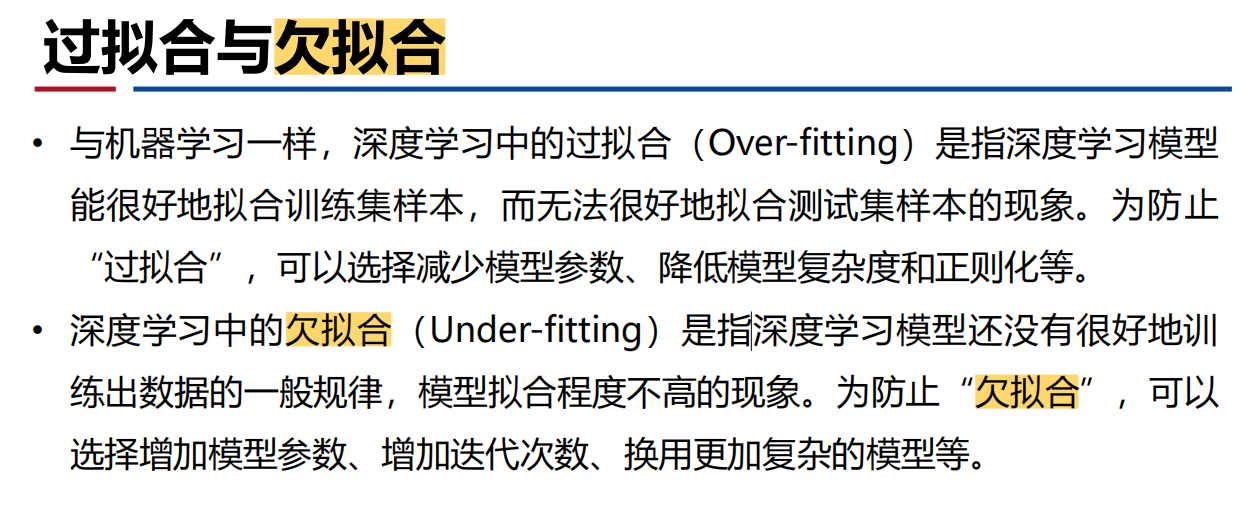

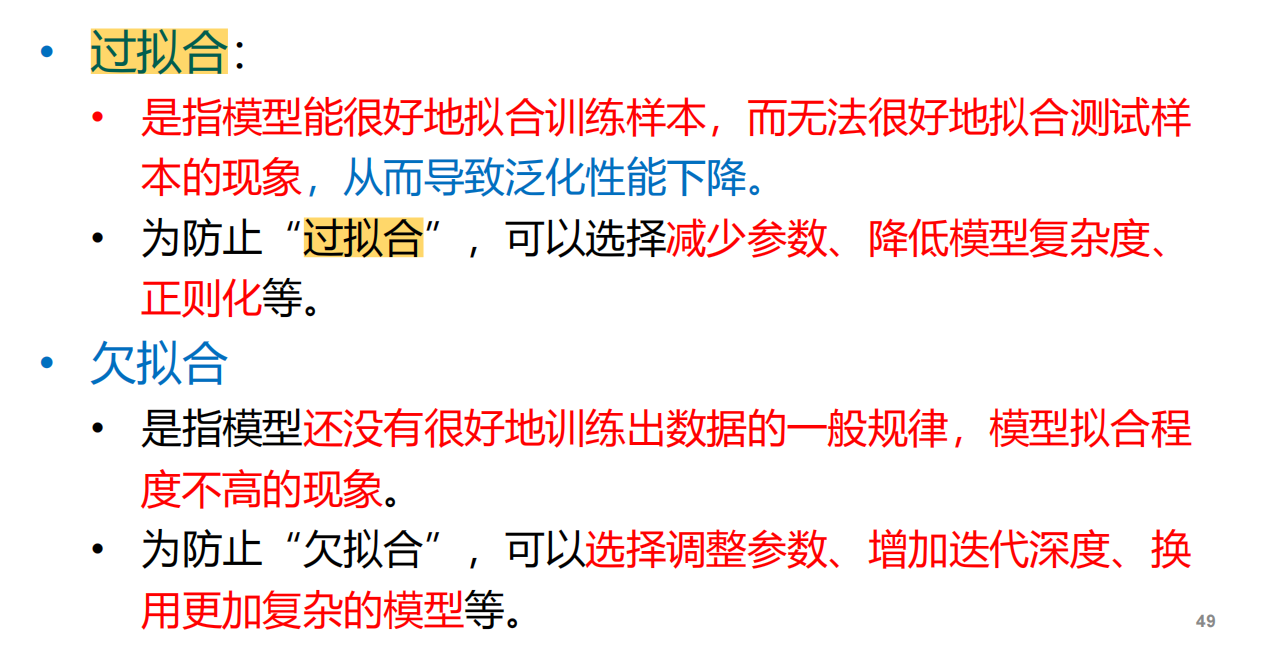

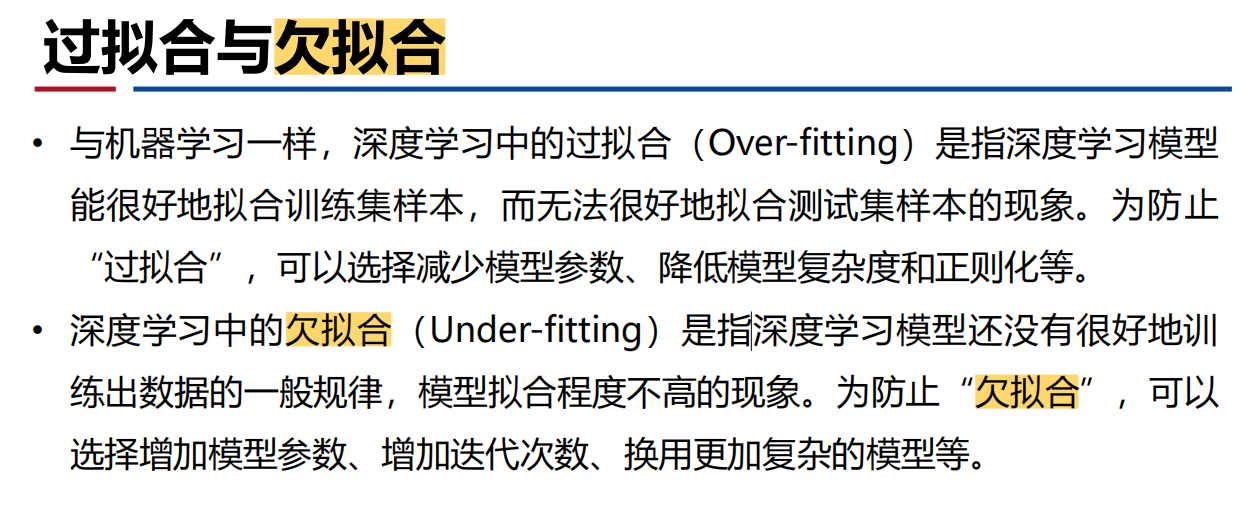

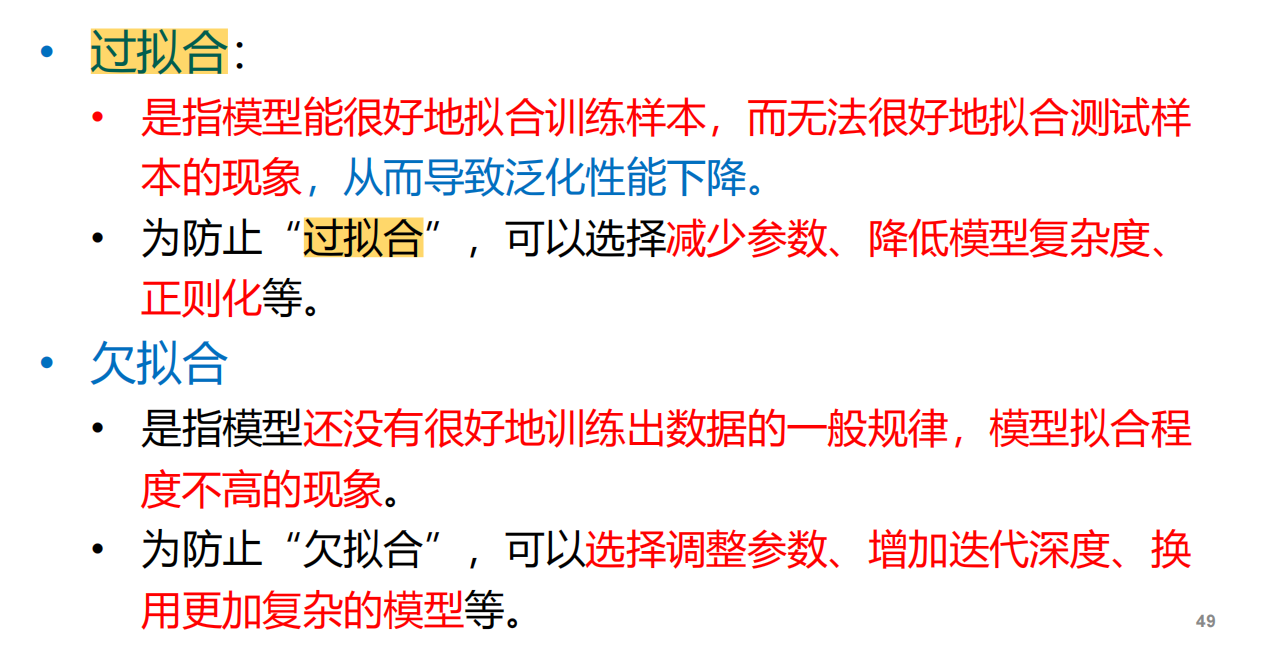

- 欠拟合与过拟合:

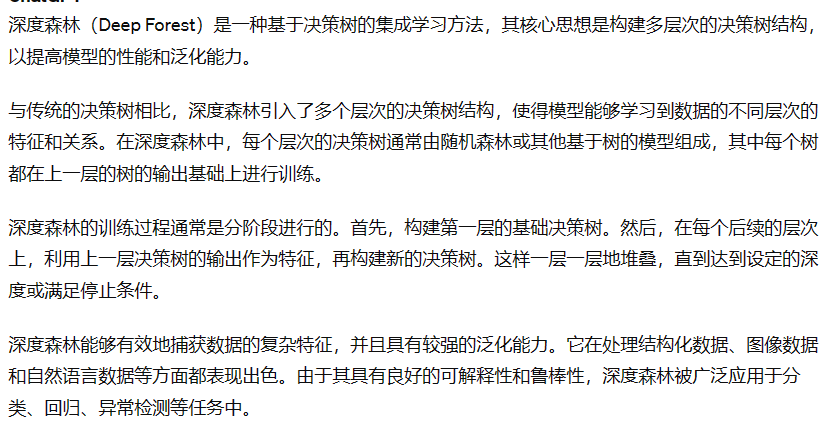

- 深度森林:

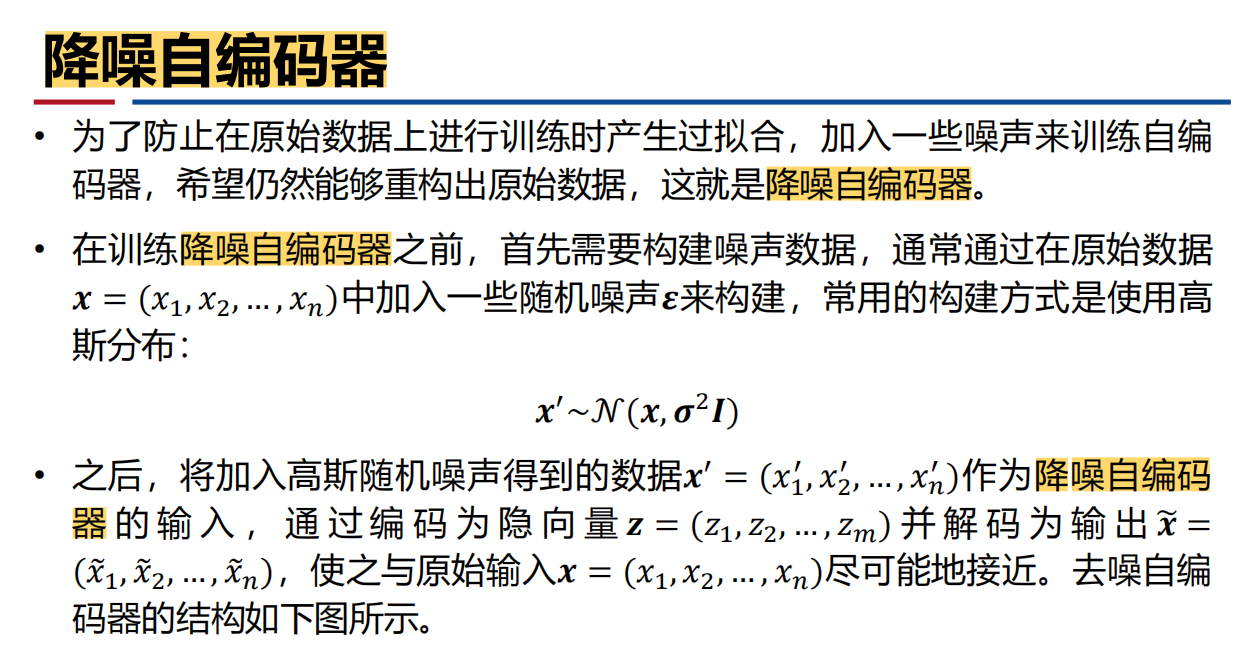

- 降噪自编码器:

- 胶囊网络:

- 深度可分离卷积:

- 目标检测:

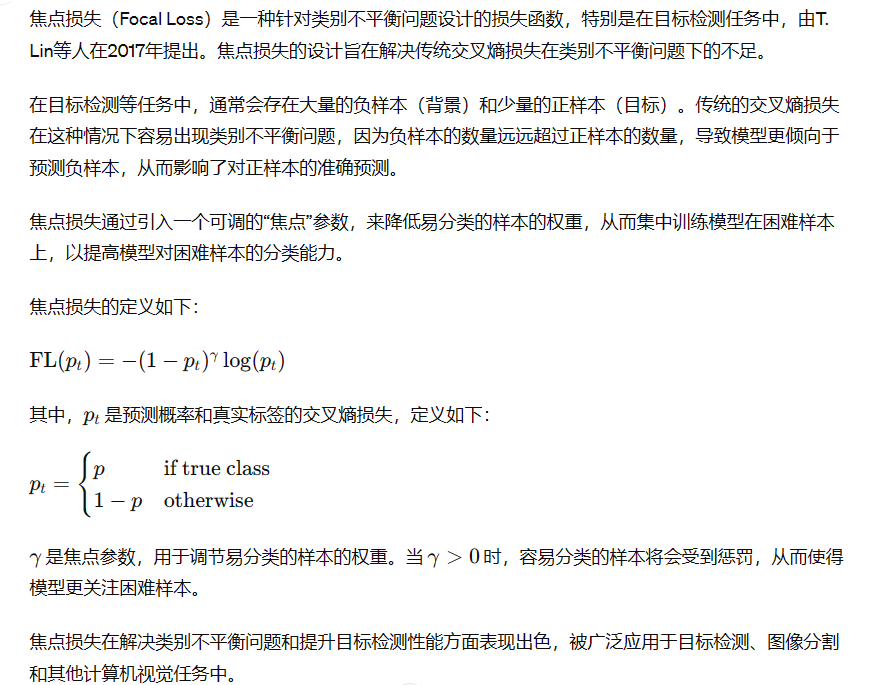

- 焦点损失:

简答题:

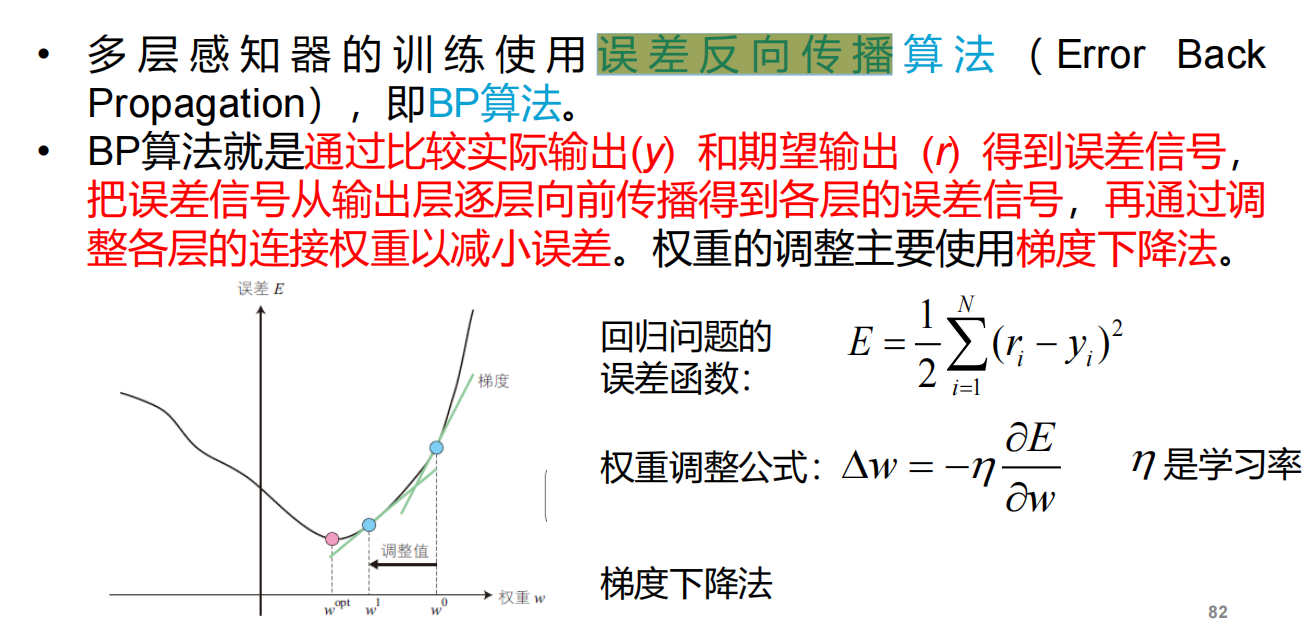

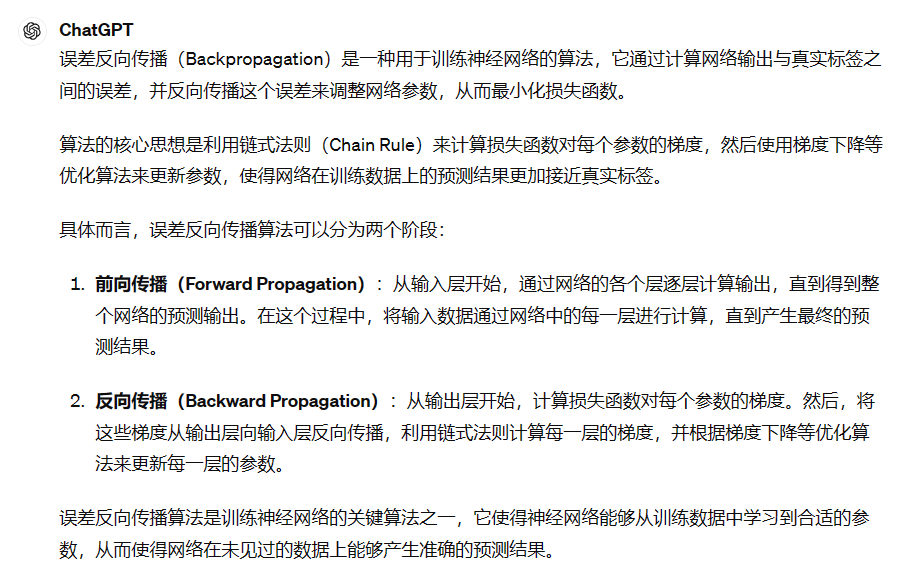

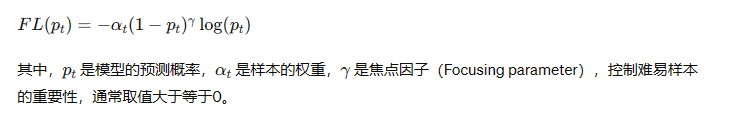

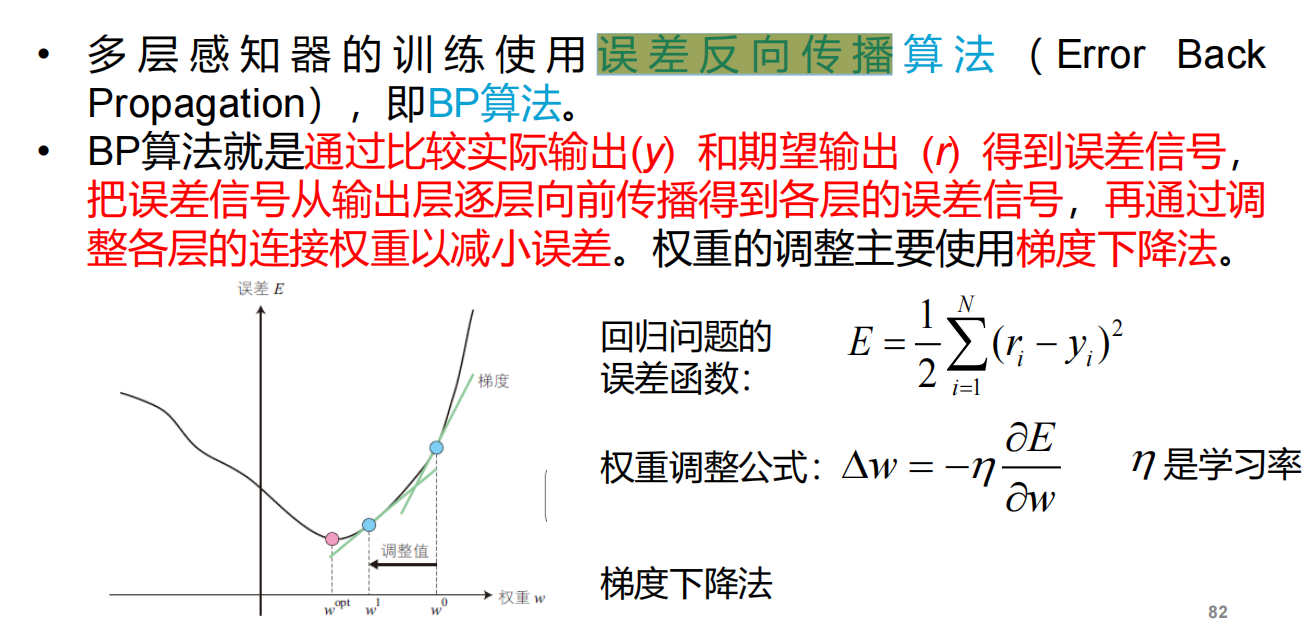

- 请简述你对误差反向传播算法的理解:

- 请列出卷积神经网络的主要结构模块,以及各个模块完成的功能——

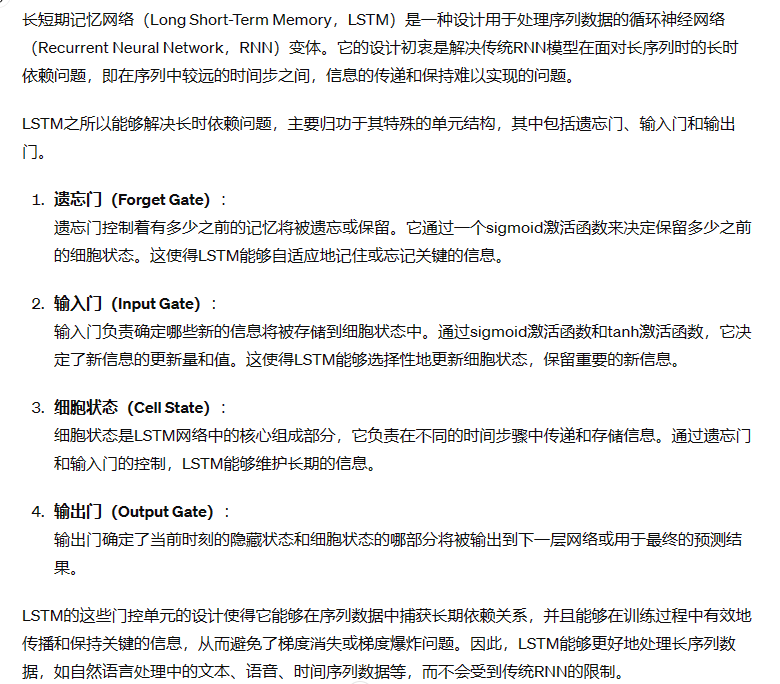

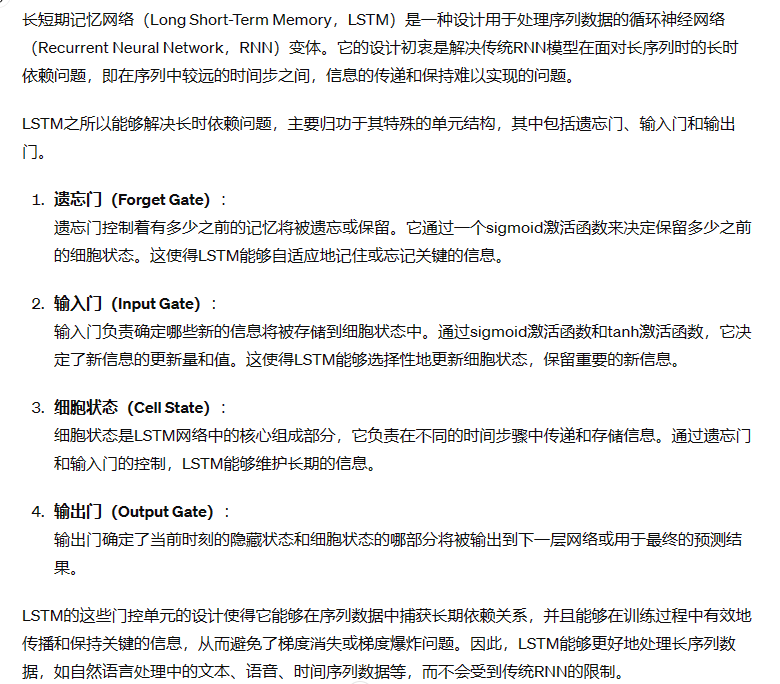

- 请简述你对LSTM的理解,并解释为什么它能够解决长时依赖问题。

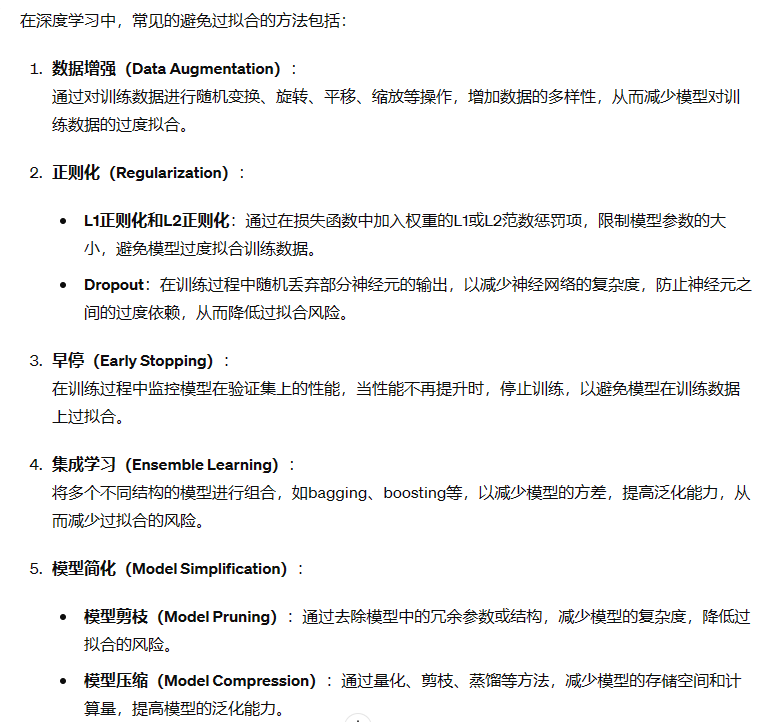

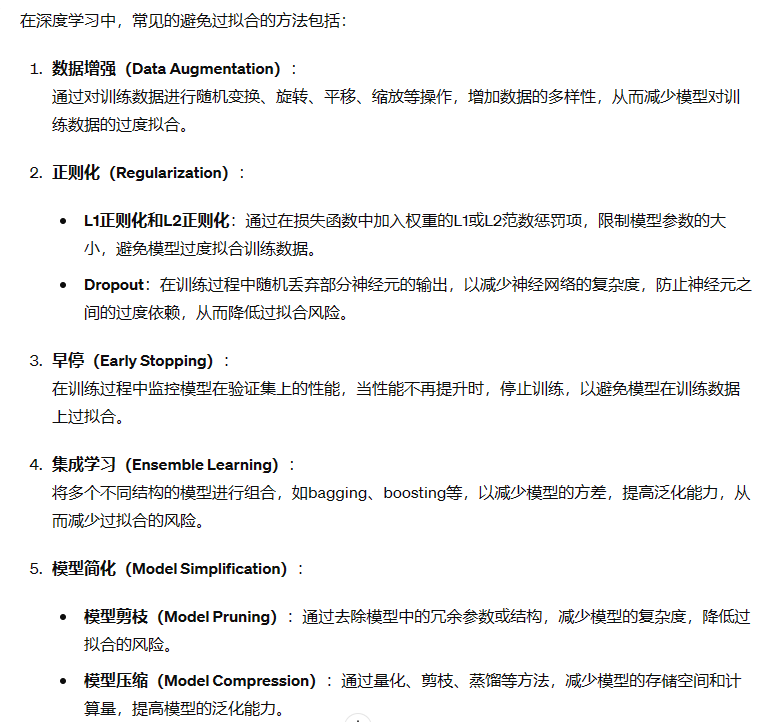

- 请简述深度学习中常见的避免过拟合的方法

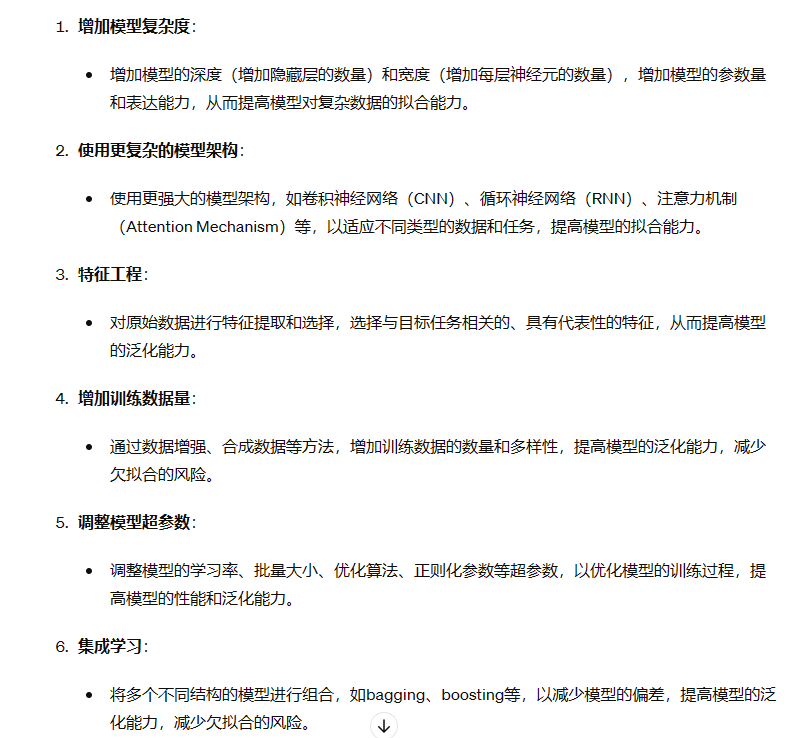

注:避免欠拟合的方法:

注:避免欠拟合的方法:

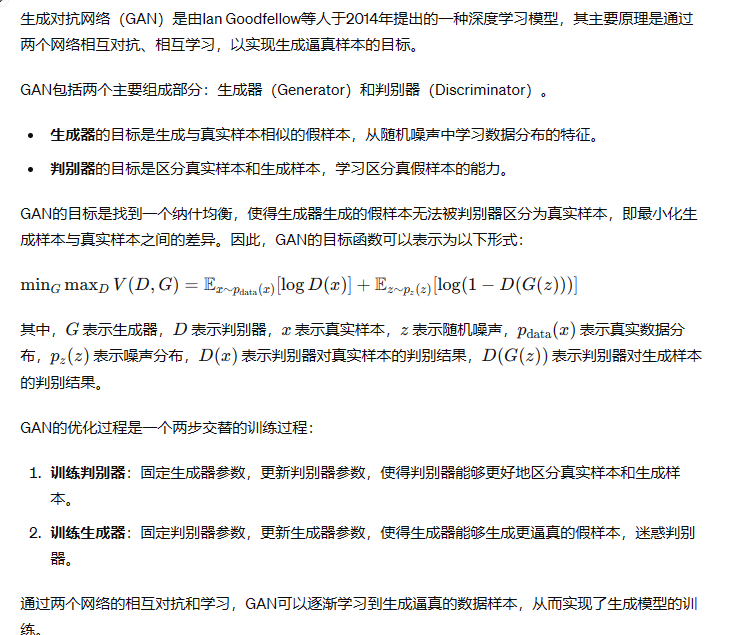

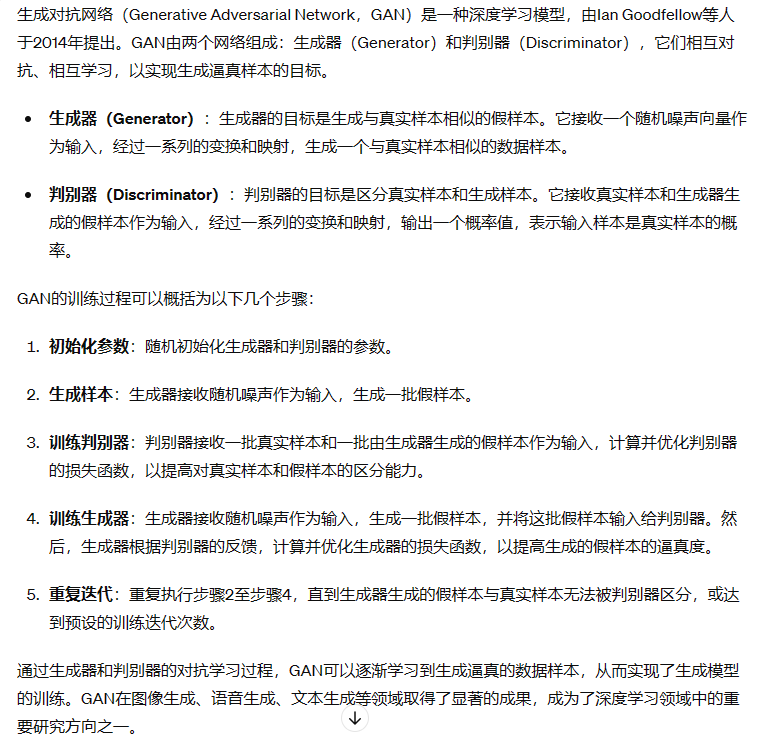

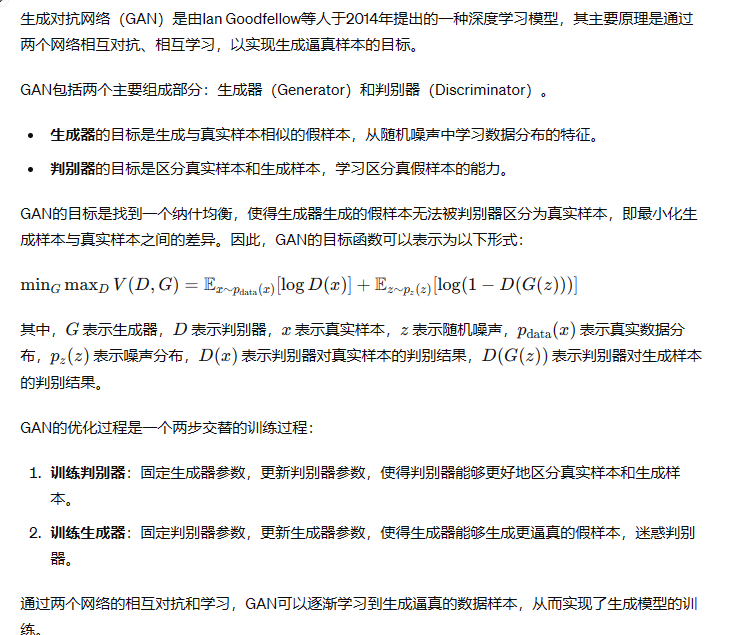

- 请简述你对生成对抗网络的理解,并简述其训练过程。

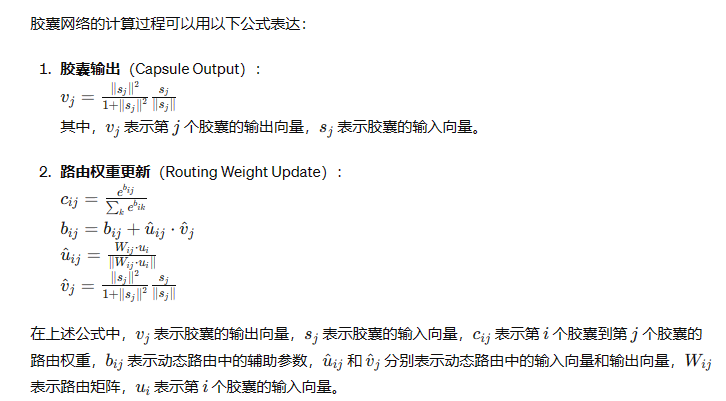

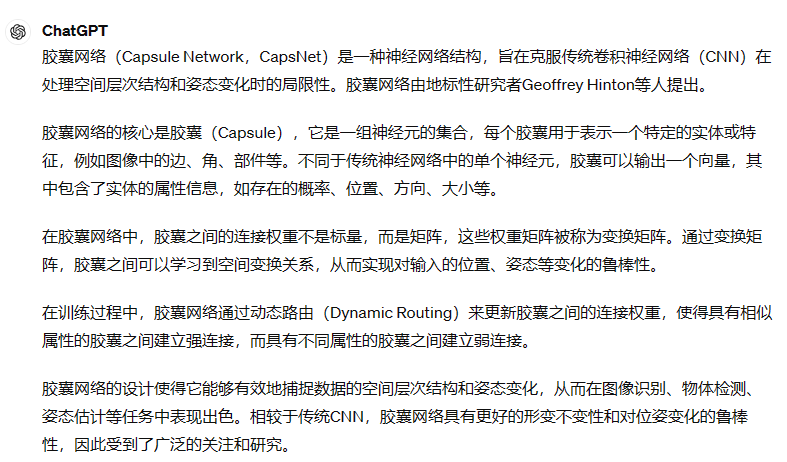

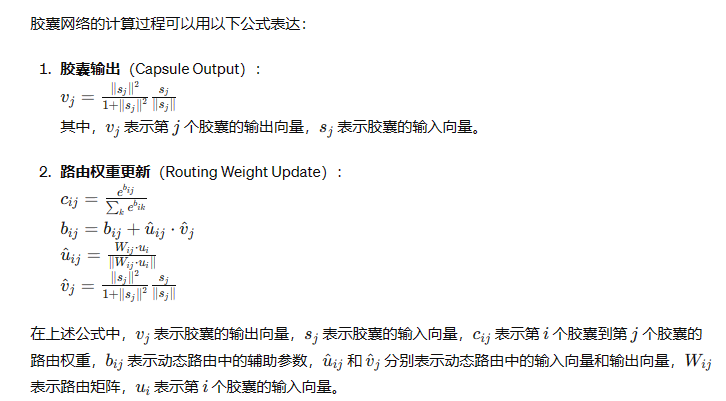

- 请简述你对胶囊网络的理解。

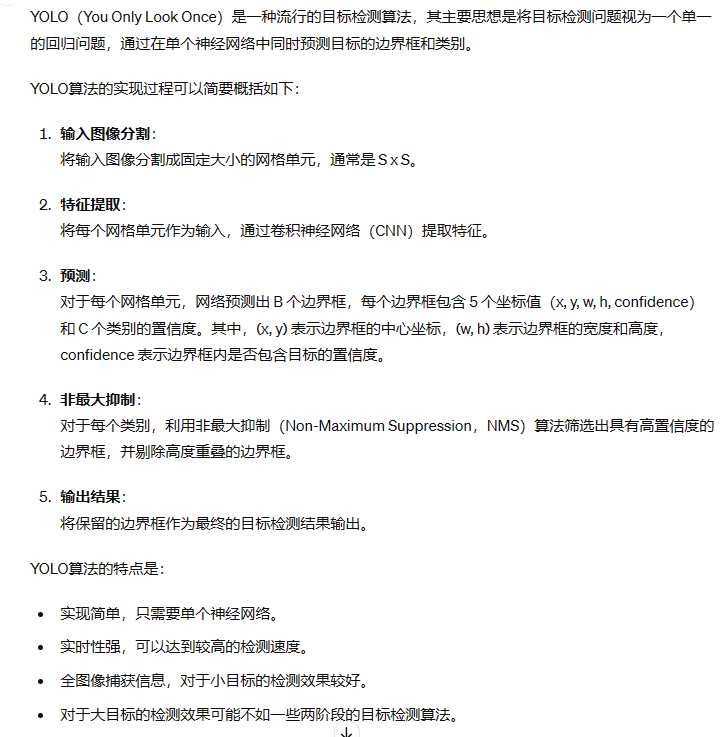

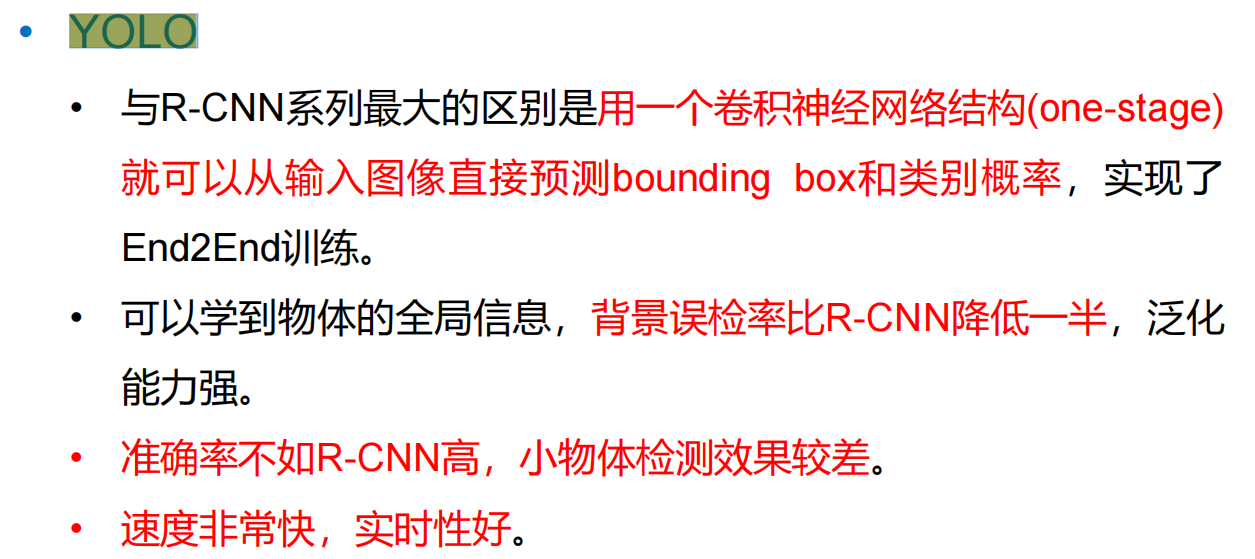

- 请简述 Yolo 算法的主要思想和实现过程

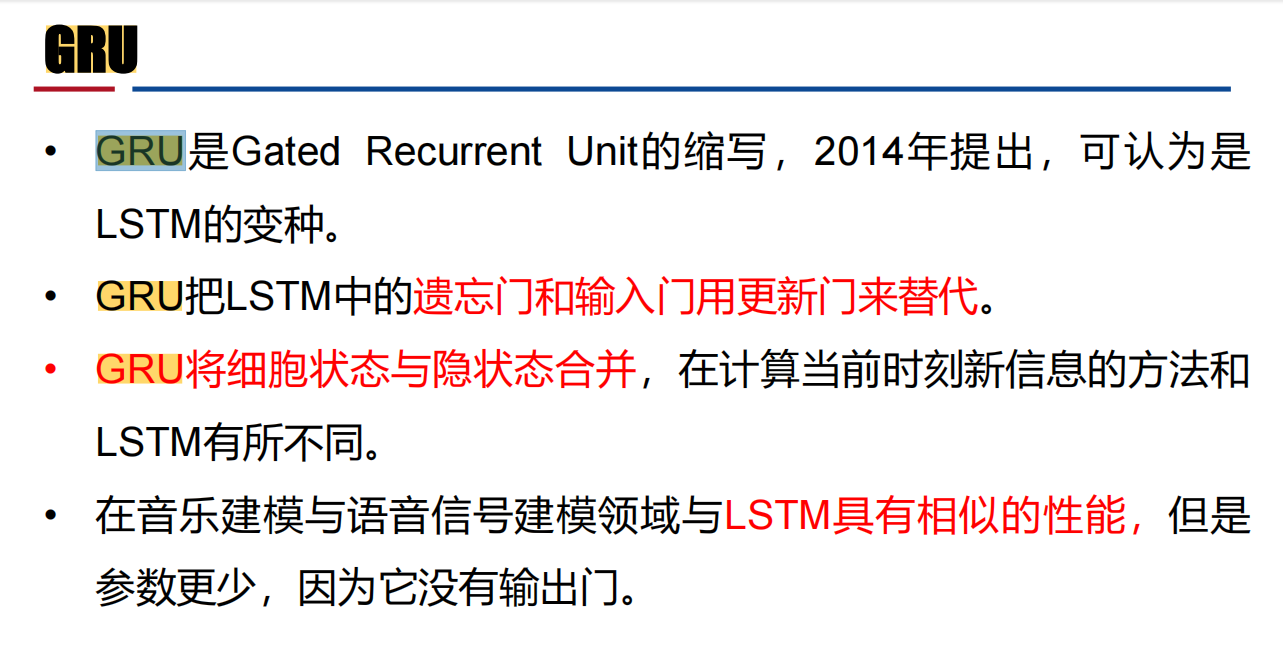

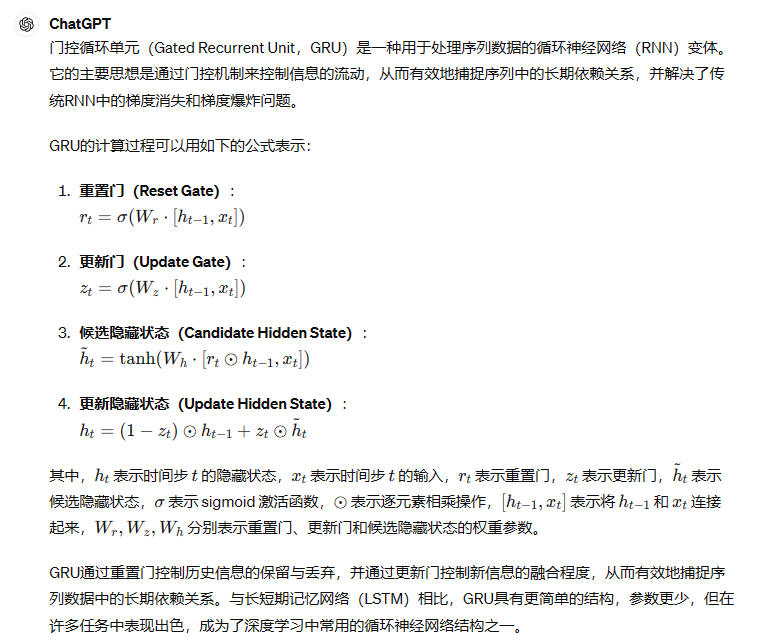

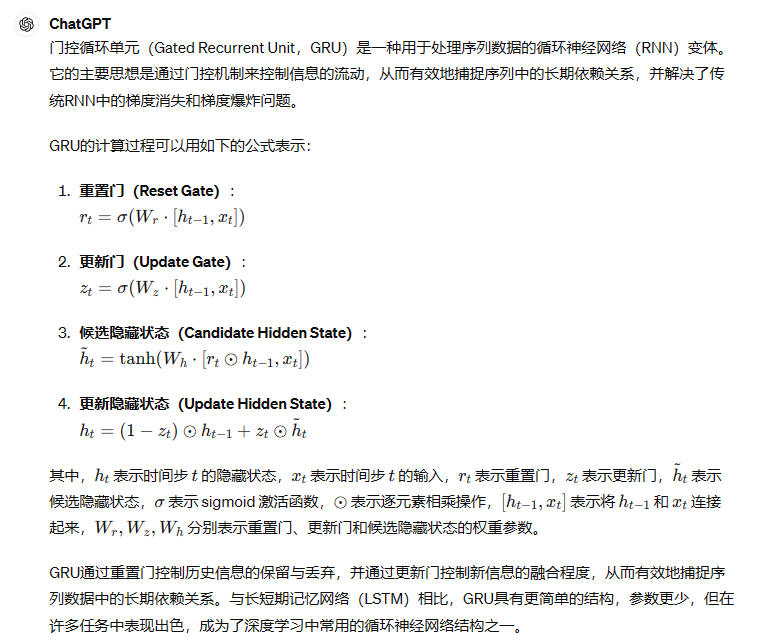

- 请简述GRU网络的主要思想,并用图和公式表达其计算过程

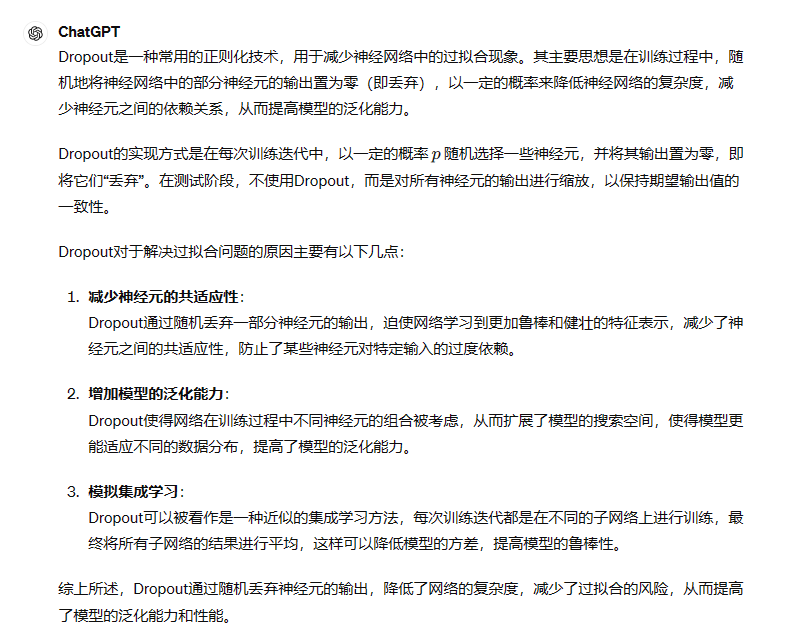

- 请简述Dropout的实现方式,并阐述你理解的它对于解决过拟合问题的原因。

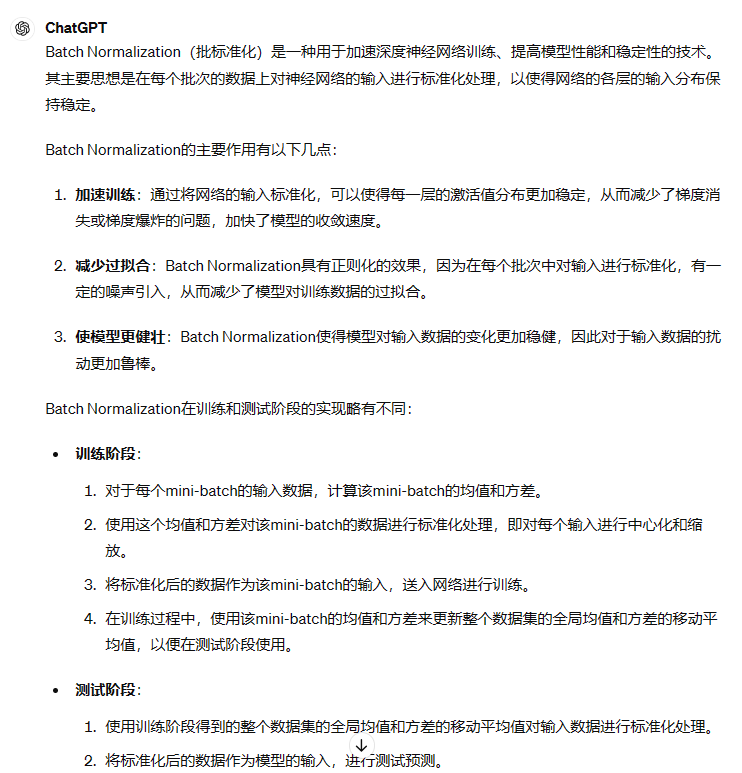

- 请简述你对Batch Normalization的理解,并说明其在训练和测试阶段如何实现?

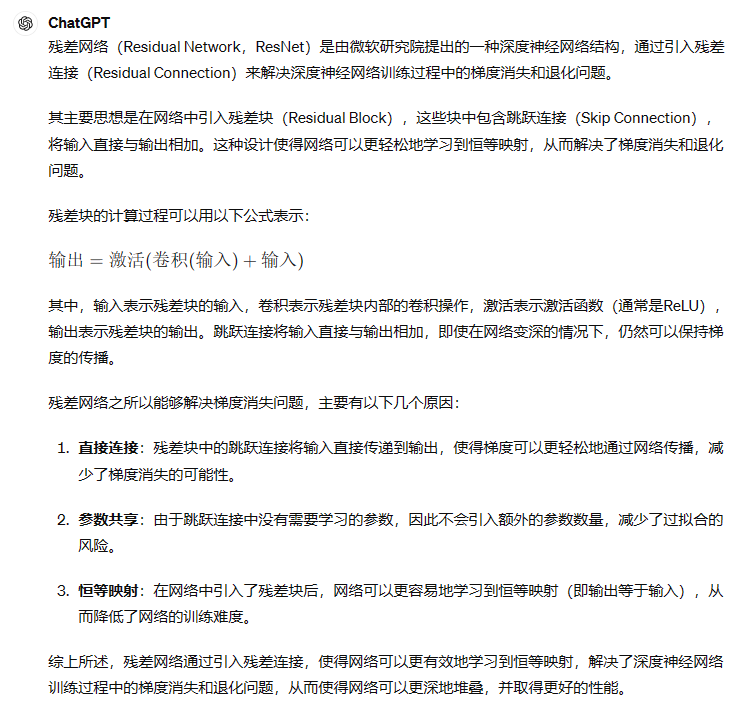

- 请简述你对残差网络的理解,并解释为什么它能够解决梯度消失问题。

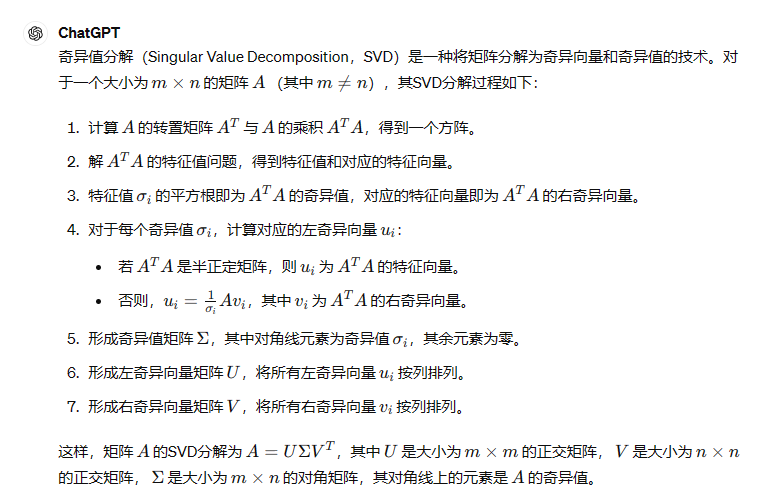

- 请写出对矩阵Amxn(m≠n)进行奇异值分解的过程。

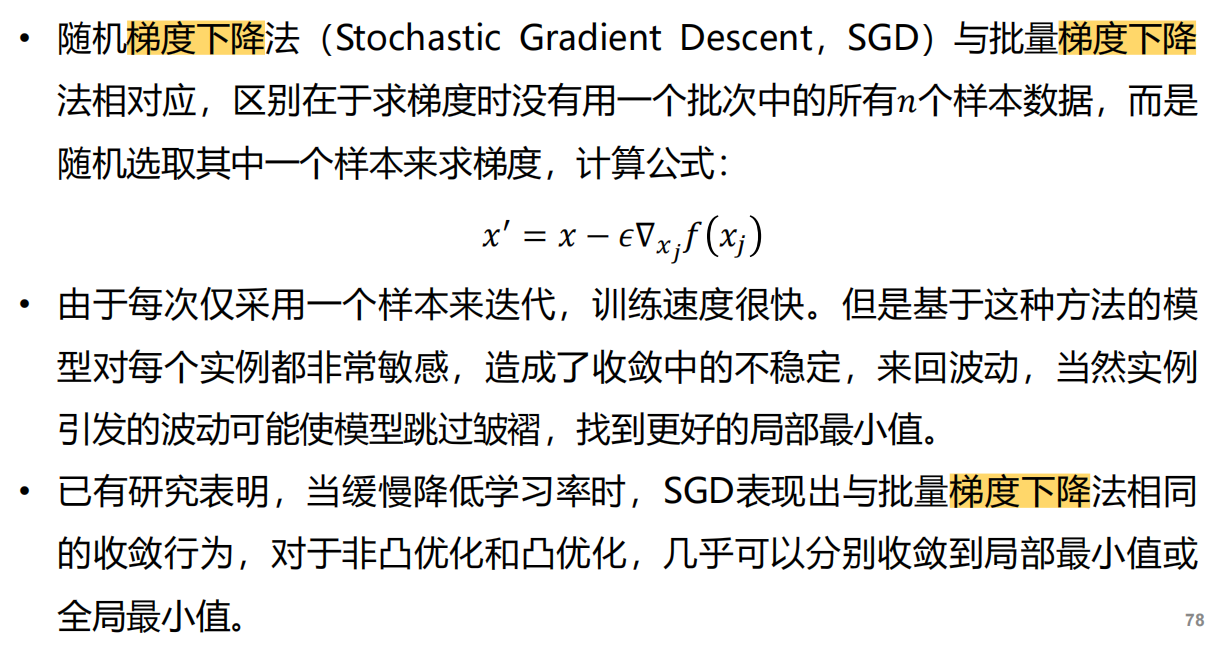

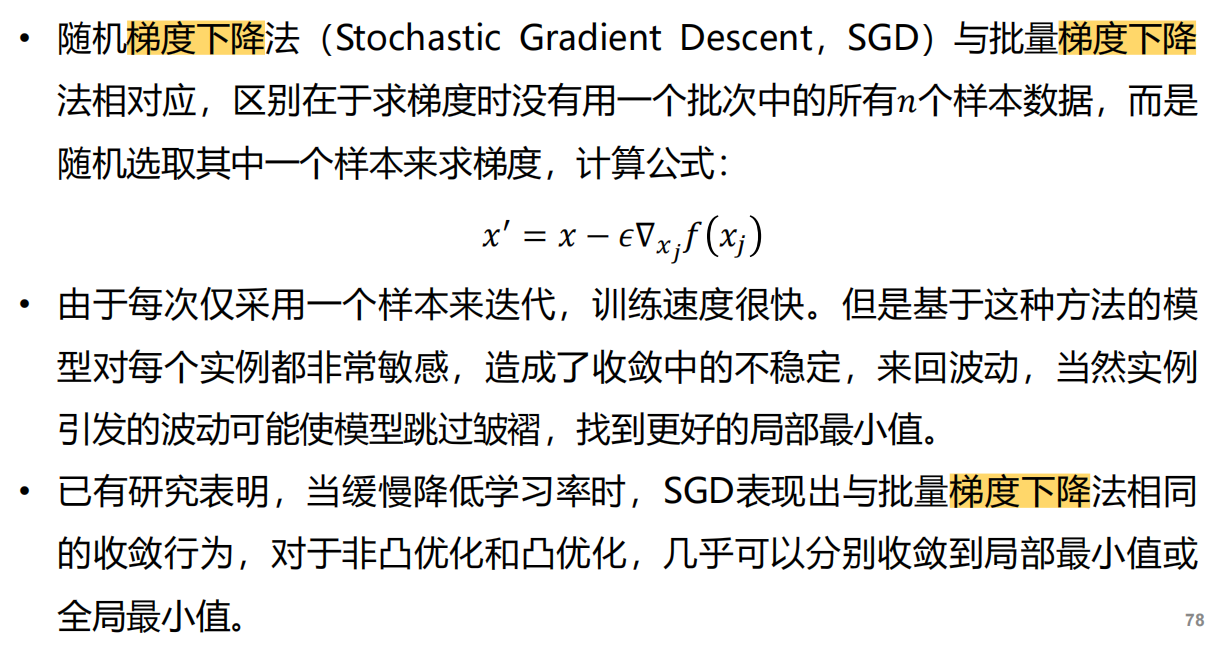

- 请简述随机梯度下降法的基本思想并图示说明

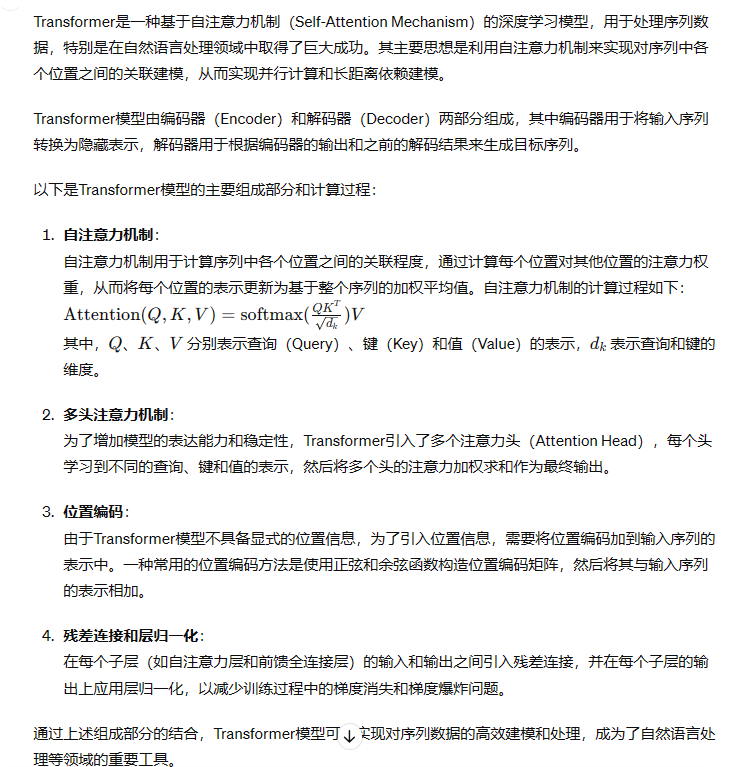

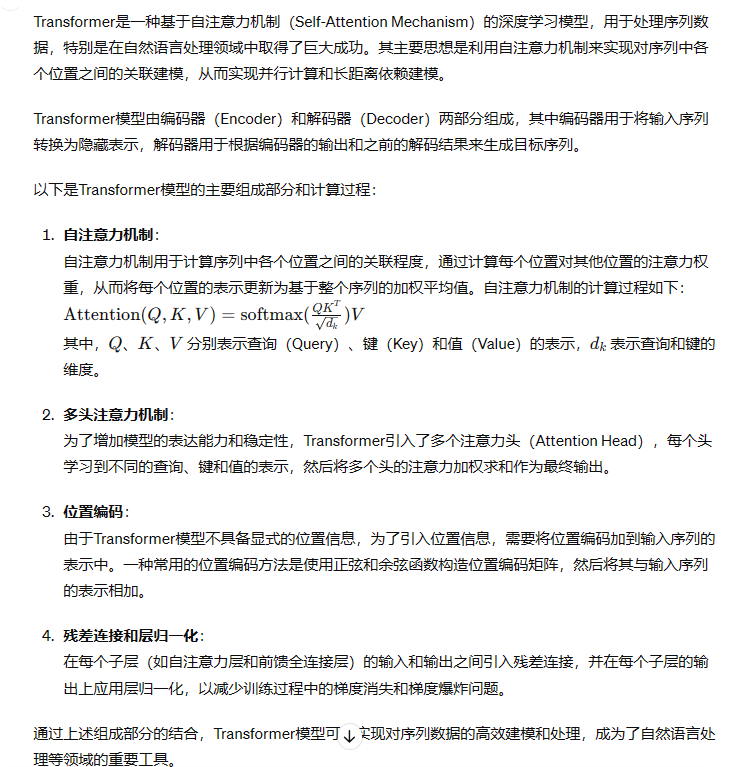

- 请简述Transformer的主要思想,并用图和公式说明。

计算:

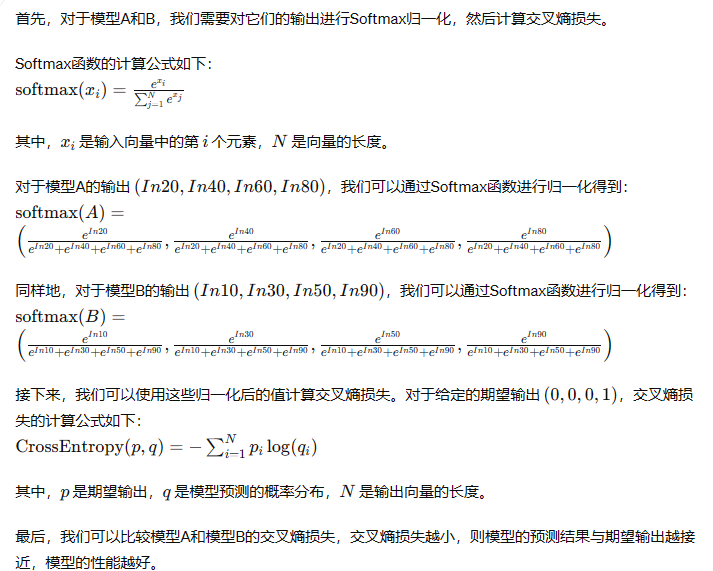

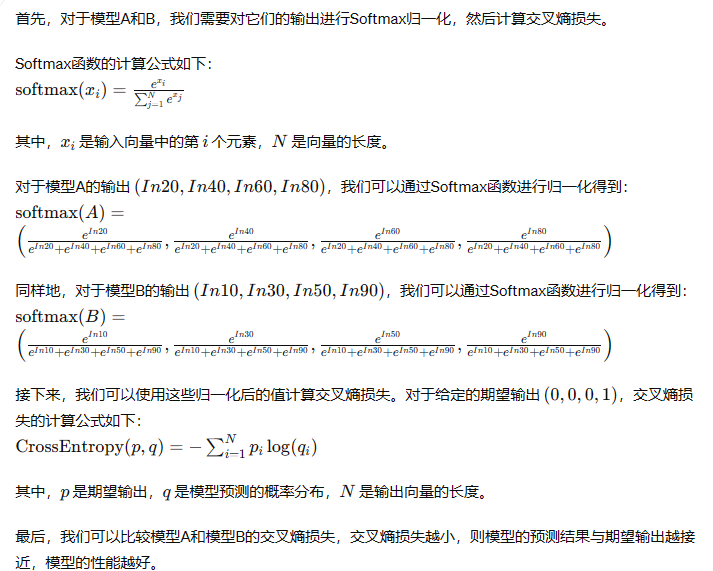

- 多分类任务中,某个样本的期望输出为(0,0,0,1),两个模型A和B都采用交叉熵作为损失函数,针对该样本的实际输出分别为(In20,In40,In60,In80)、(In10,In30,ln50,In90),采用Softmax 函数对输出进行归一化并计算两个模型的交叉熵,说明哪个模型更好。提示:lg2≈0.301,lg3≈0.477。

- 计算焦点损失:

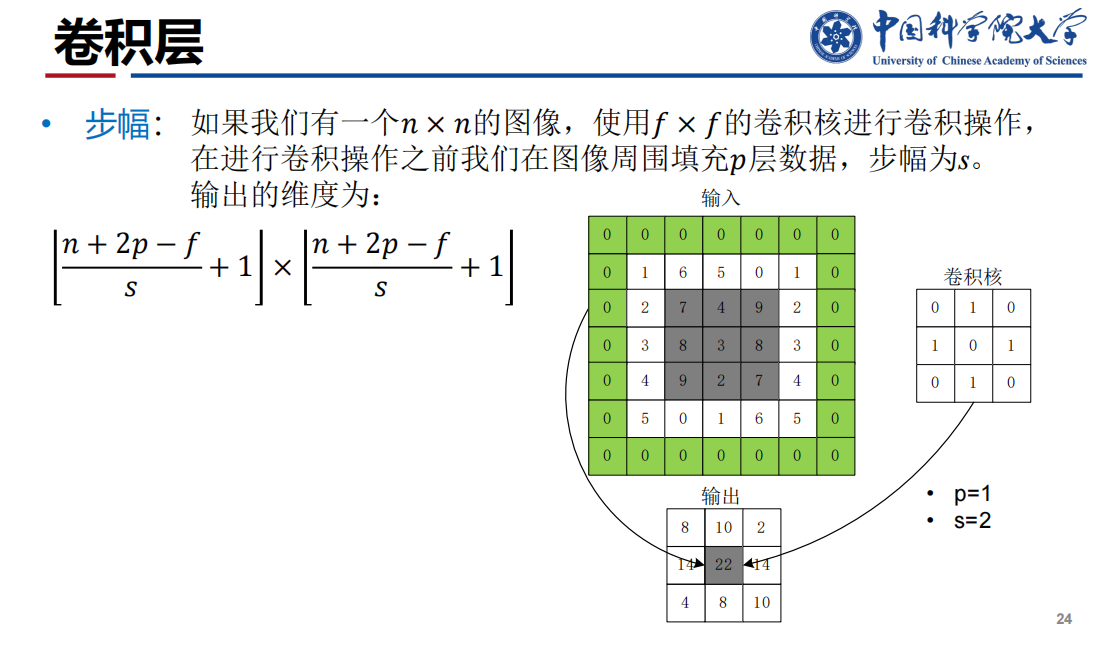

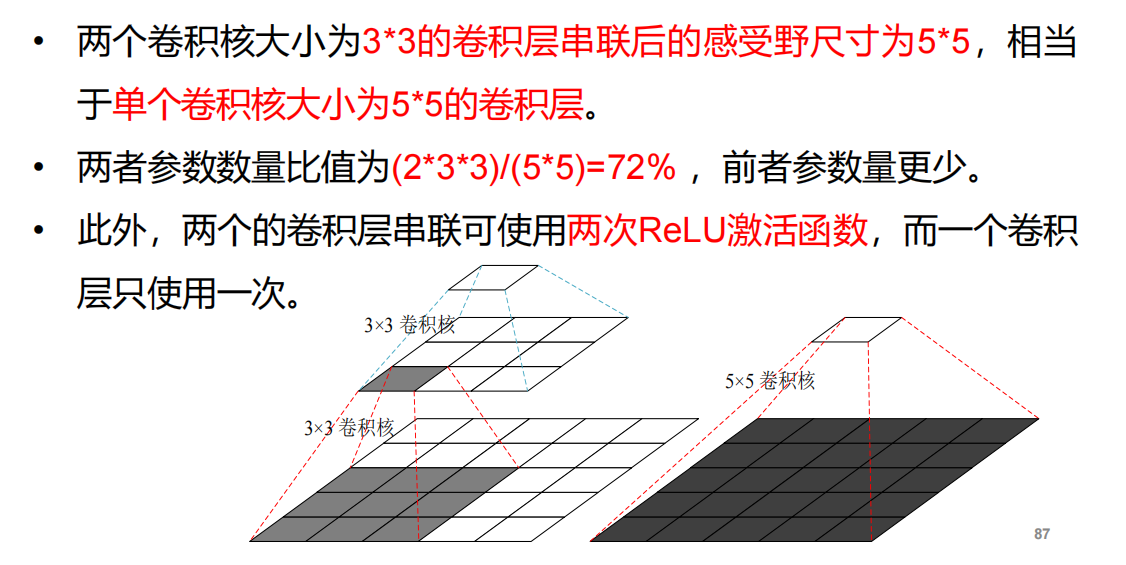

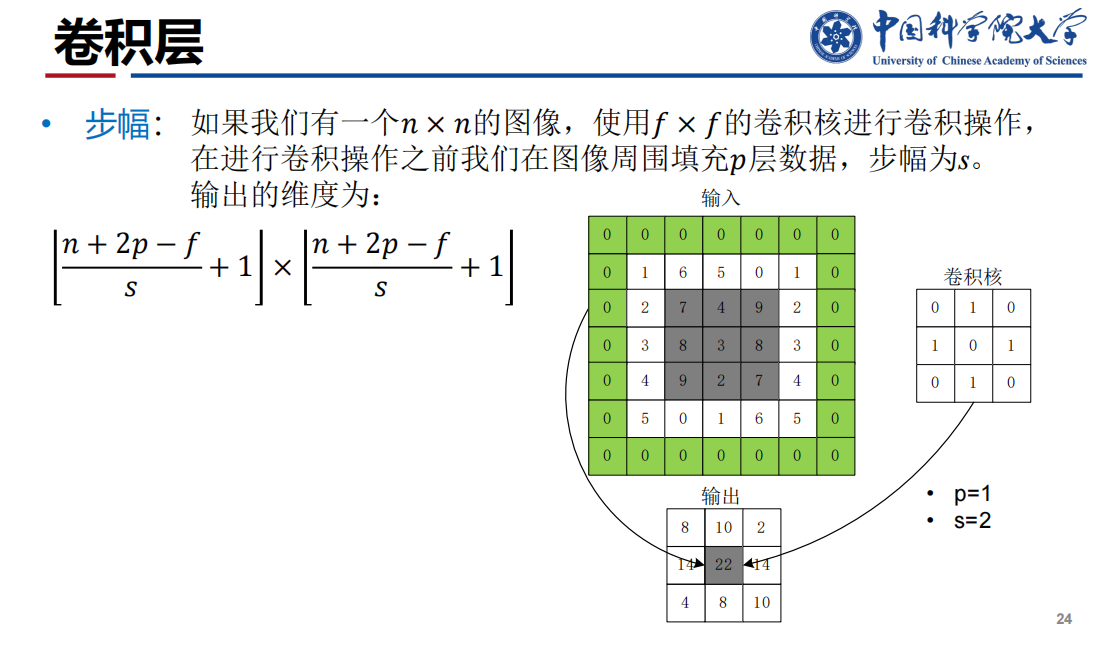

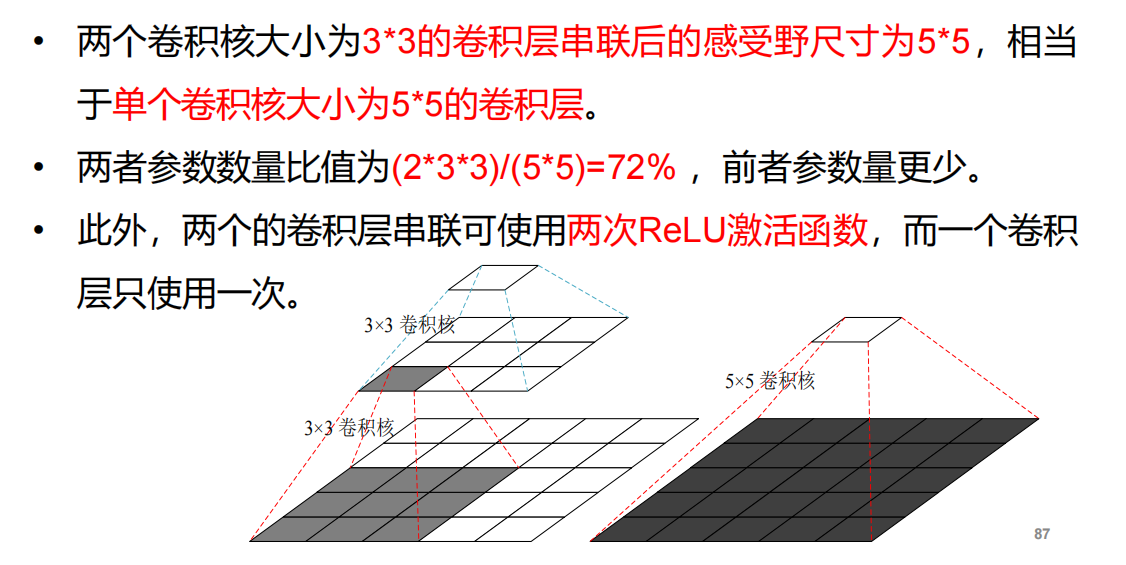

- 计算感受野:

注:最后等于1就行

注:最后等于1就行

- 计算参数量:卷积核大小 X 深度 X 通道数【特征图的通道数和前面所选卷积核深度相关】

注:避免欠拟合的方法:

注:避免欠拟合的方法:

注:最后等于1就行

注:最后等于1就行