——基础工具

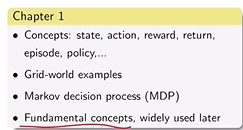

- 第一章【基本概念】:

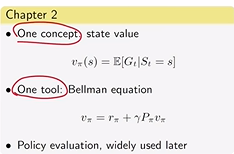

- 第二章【贝尔曼公式】:策略评价

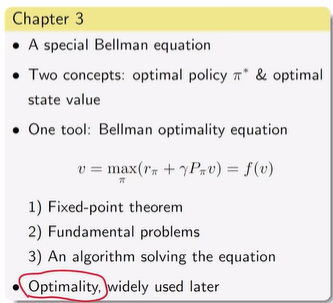

- 第三章【贝尔曼最优公式】:强化学习的最终目标?【求解最优策略】

——算法和反馈

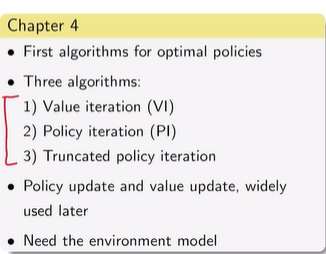

——算法和反馈 - 第四章【最优策略的算法】:有模型的值迭代/策略迭代

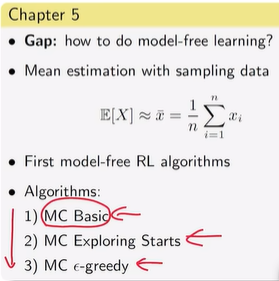

- 第五章【无模型的】:不需要模型找最优策略——学习随机变量的期望值【通过随机采样、MC basic/MC Exploring Starts/MC ɛ-greedy 】

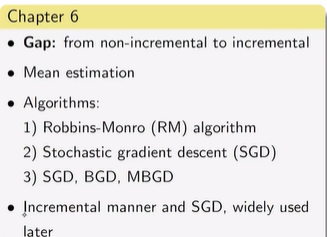

- 第六章【随机近似理论】:from non-incremental【如我有一万个样本,我要等采样所有后才求平均】 to incremental【开始有一个可能不准的估计,得到一次采样就更新一次估计】

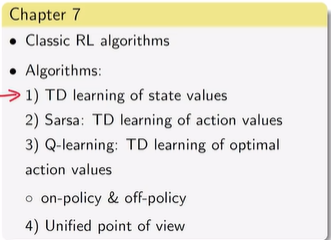

- 第七章【时序差分】:

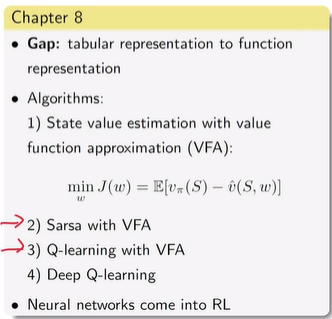

- 第八章【状态连续或状态特别多时的——函数Vhat】:神经网络首次进入到强化学习中

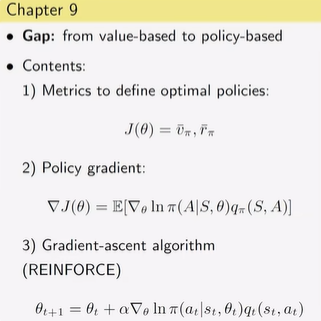

- 第九章【由value-based到policy-based的跳跃】:

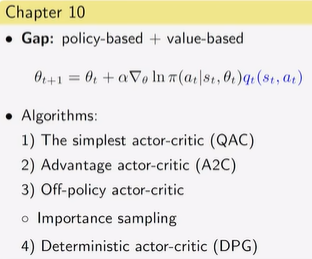

- 第十章【policy-based+value-based】:

- 课程是否适合你?——课程特点:强化学习的原理;数学的角度讲故事

强化学习背景

- AlphaGo:

- 围棋界战无不胜——掀起强化学习的热潮

- AlphaGo Zero:战胜AlphaGo

- 强化学习历史:

- Deep Q-learning:Q-learning【特殊的Temporal-difference learing时序差分】

- Dynamic programming【动态规划】:离散时间/离散状态

- 强化学习分类

- 人工智能

- 机器学习

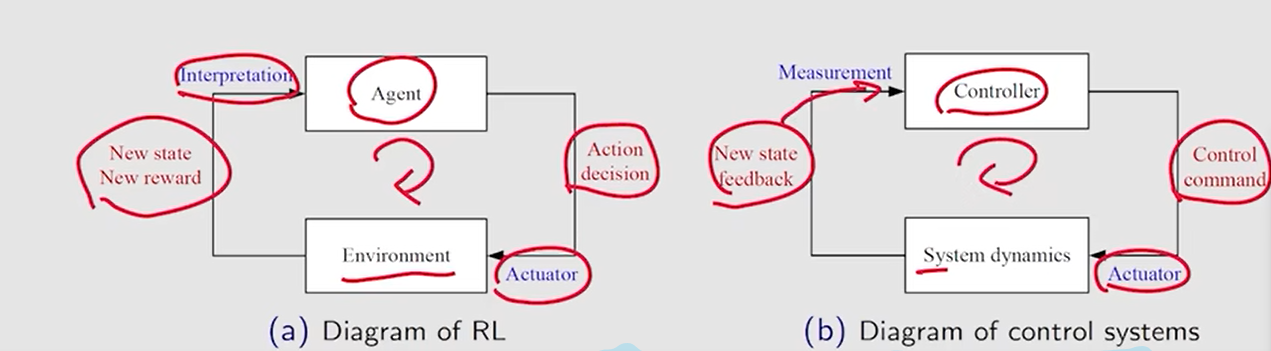

- 强化学习的范式: